![]()

文 / Google Research Cloud AI 团队研究员 Jinsung Yoon 和 Sercan O. Arik

近期研究表明,并非所有的数据样本对训练都同样实用,深度神经网络 (DNN) 在这一点上表现得尤其明显。事实上,如果数据集包含低质量或错误标记的数据,通常可以移除一大部分训练样本来提高性能。此外,在训练数据集和测试数据集不匹配的情况下(例如,训练和测试的地点或时间不同),也可以将训练集中的样本严格限制为与测试场景最相关的样本,从而提高表现。由于这些场景的普遍性,准确量化训练样本的价值对于提高真实世界数据集上的模型性能具有很大潜力。

![]()

![]()

上:低质量样本(噪声/众包)示例;下:训练和测试数据不匹配示例

除了提高模型性能外,为单个数据分配一个质量值还可以实现新的用例。这也为数据收集提供了建议,例如,哪种额外的数据最有益;也可以用于更高效地构建大规模的训练数据集,例如,使用标签作为关键字进行网络搜索,过滤掉价值较低的数据。

在收录于 ICML 2020 的“使用强化学习进行数据评估” _(Data Valuation Using Deep Reinforcement Learning) _中,我们使用基于元学习的全新方法解决了量化训练数据价值的问题。我们的方法将数据估值整合至预测器模型的训练过程中,该模型学习识别对于给定任务具有更高价值的样本,从而改善预测器和数据估值的性能。我们还推出了四个 AI Hub Notebook,它们展现了 DVRL 的用例,旨在高效适应其他任务和数据集,如 领域自适应、损坏样本发现与鲁棒学习、图像数据的迁移学习 和 数据估值。

量化数据的价值

对于给定的 ML 模型,并非所有数据都是平等的 - 部分数据与当前任务的相关性更高,或者信息量比其他数据更丰富。那么如何评估单个数据的价值呢?以完整数据集的粒度而言,这很简单;只需在整个数据集上训练模型,然后将其在测试集上的性能作为该值。不过,估计单个数据的价值要困难得多,特别是对于依赖大规模数据集的复杂模型而言,因为在所有可能的子集上重新训练和重新评估模型在计算上是不可行的。

为了解决这个问题,研究人员探索了基于置换的方法(如 影响函数)和基于博弈论的方法(如 data Shapley)。然而,对于大型数据集和复杂模型而言,即使是当前最好的方法在计算上也远非可行,并且其数据估值性能也受到一定限制。同时问世的 基于元学习的自适应权重分配方法 可以利用元目标估计权重值。其数据价值映射并不优先从高价值数据样本中学习,而通常基于梯度下降学习或其他启发式方法,改变了常规预测器模型训练动态,避免了与单个数据点价值无关的性能变化。

**使用强化学习进行数据估值 (DVRL) **

为了推断出数据价值,我们提出了一个数据价值估计器 (DVE),用以估计数据价值并选择最高价值的样本来训练预测器模型。这种选择运算完全不可微,因此不能采用基于梯度下降的传统方法。取而代之的是,我们采用了强化学习 (RL),使 DVE 的监督基于奖励,该奖励在一个小的(但干净的)验证集中量化预测器性能。给定状态和输入样本后,奖励将政策的优化引导至最优数据估值的操作。在此,我们将预测器模型学习和评估框架视为环境,这是 RL 辅助机器学习的一种新型应用场景。

![]()

通过使用强化学习的数据估值 (DVRL) 进行训练。当训练具有准确率奖励的数据价值估计器时,最高价值样本(绿点)的使用频率会越来越高,而最低价值样本(红点)的使用频率则较低

结果

我们在多种类型的数据集和用例上评估了 DVRL 的数据估值质量。

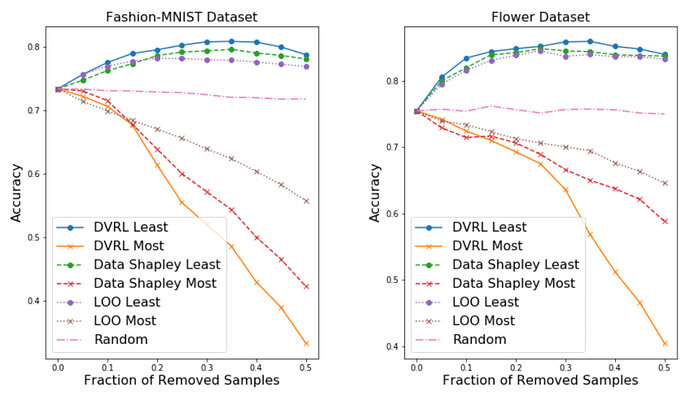

- 移除高/低价值样本后的模型性能

从训练数据集中移除低价值样本可以提高预测器模型的性能,在训练数据集包含损坏样本的情况下尤其明显。另一方面,移除高价值样本,特别是数据集较小时,会显著降低性能。总体而言,移除高/低价值样本后的性能是数据估值质量的有力指标。

移除最高价值和最低价值样本后的准确率,其中 20% 的标签设计为具有噪声。移除最低价值样本之类的噪声标签后,高质量的数据估值方法可以获得更好的准确率。从这个角度来看,可以证明 DVRL 明显优于其他方法

-

大多数情况下,DVRL 在移除最重要的样本后性能下降最快 ,而在移除最不重要的样本后性能下降最慢 。这凸显了 DVRL 相较于竞争方法(Leave-One-Out 和 Data Shapley)在识别噪声标签方面的优势。

-

噪声标签的稳健学习

我们考虑的是,DVRL 在不移除低价值样本的情况下,以端到端方式使用噪声数据进行学习的可靠性。理想情况下,随着 DVRL 收敛,噪声样本应获得低数据价值,并返回高性能模型。

![]()

噪声标签的稳健学习。ResNet-32 和 WideResNet-28-10 在 CIFAR-10 和 CIFAR-100 数据集上的测试准确率,标签上具有 40% 的均匀随机噪声。DVRL 优于其他基于元学习的流行方法

-

我们展示了 DVRL 在最小化噪声标签影响方面的最先进结果 (SOTA)。这也证明 DVRL 可以扩展到复杂模型和大规模数据集上。

-

领域自适应

我们考虑的场景是,训练数据集来自与验证和测试数据集有实质性差异的分布。通过从训练数据集中选择与验证数据集分布最匹配的样本,数据估值有望对该任务提供帮助。我们关注以下三种情况:

- 基于图像搜索结果的训练集(低质量网络抓取),应用于使用 HAM 10000 数据预测皮肤病变分类的任务(高质量医疗);

- MNIST 训练集,用于 USPS 数据的数字识别任务(不同视域);

- 垃圾邮件数据,应用于 SMS 数据集垃圾邮件检测(不同任务)。

DVRL 将数据估值器和对应预测器模型联合优化,显著改善了领域自适应。

![]()

结论

我们为数据估值提供了一种全新的元学习框架,它可以确定每个训练样本被用于预测器模型训练的可能性。与过去不同,我们的方法将数据估值整合到预测器模型的训练过程中,使预测器和 DVE 能够相互提高性能。我们使用经 RL 训练的 DNN 对此数据价值估计任务进行建模,并从代表目标任务性能的小型验证集中获得奖励。DVRL 能够以高计算效率的方式提供高质量的训练数据排名,这对领域自适应、损坏样本发现和稳健学习十分有用。我们证明 DVRL 在多种类型的任务和数据集上均明显优于其他方法。

致谢

我们非常感谢 Tomas Pfister 的贡献。

![]()

原文:Estimating the Impact of Training Data with Reinforcement Learning

中文:谷歌开发者公众号