文 / 研究员 Daniel Ramage 和软件工程师 Stefano Mazzocchi, Google Research

借助 联邦学习(Federated Learning,于 2017 年推出),开发者无需集中收集数据即可在多部设备上训练机器学习 (ML) 模型,确保用户数据保留在设备端,且能优化多种体验:如 Android 版 Gboard 的下一词汇预测和表情包建议,以及提升 Android 消息的智能回复质量等。

随着此类应用不断取得成功,开发者愈发倾向于使用联邦技术来解决关于去中心化数据的更多基本问题,如,不涉及机器学习的数字或费率计算之类的问题。使用这些技术来分析用户行为可进一步改进产品,并确保基础数据的私密性和安全性。

今天,我们将介绍 联邦分析 (Federated Analytics) ,一种 数据科学方法实践,用于分析存储在用户本地设备中的原始数据 。与联邦学习的原理类似,通过对每部设备的数据进行本地计算,并且仅向产品端提供汇总结果(不提供来自特定设备的任何数据)。与联邦学习不同,联邦分析的目标是满足基本数据科学需求。

本文将介绍为推动联邦学习而设计的联邦分析基本方法、我们如何将之扩展至新领域,以及联邦技术的最新进展如何满足不断增长的数据科学需求,并实现更好的准确性和私密性。

联邦分析起源

对联邦分析技术的首次研究是为了支持联邦学习:当数据中心中没有可用的数据时,工程师如何依据现实数据来评估联邦学习模型的质量?我们得到的答案是重新使用联邦学习的基础架构,但删除 学习 部分。在联邦学习中,模型定义不仅可以包括要优化的损失函数,还可以包括用于计算模型预测质量的指标的代码。这类代码可以直接在手机端运行,通过数据衡量模型的质量。

举例来说,Gboard 工程师可根据用户手机上保存的原始键入数据来评估下一字词预测模型的整体质量。参与研究的手机会下载一个候选模型,并在本地计算评估模型预测结果与实际键入字词之间的匹配程度的指标,然后再上传该指标。此过程中,无需对模型的权重进行调整或对 Gboard 的键入体验进行更改。通过对多部手机上传的指标数据求取平均值,工程师便能获取模型性能总体水平的概要信息。这项技术还可以轻松扩展至预估基本统计数据(如数据集大小)等方面。

歌曲识别评估的联邦分析

不只是模型评估,联邦分析还可支持 Google Pixel 手机上的 闻曲知音功能 (Now Playing),帮您识别周围环境正在播放的歌曲名称的工具。“闻曲知音” 功能可在后台使用设备上的歌曲指纹数据库来识别手机附近正在播放的音乐,而无需连接网络。此架构处理速度快、可离线工作,并且所有原始或处理后的音频数据都保留在手机上,因此有利于隐私保护,且便于用户使用。由于同一个区域内的每部手机均接收相同的数据库,并且只能识别数据库中存在的歌曲,因此对于数据库而言,保存正确的歌曲非常重要。

为评估和提高每个区域数据库的质量,工程师需要回答一个基本问题:用户最常识别的是哪类歌曲?联邦分析提供了答案,且不会透露任意一台手机收听的歌曲信息。此功能已在同意向 Google 发送设备相关使用情况和诊断信息的设备上启用。

“闻曲知音” 功能识别出歌曲后,会将谁别的曲目名称记录在设备上 “闻曲知音” 的历史记录中,用户可在历史记录中查看最近识别的歌曲,并添加到音乐应用的播放列表中。之后,当手机处于空闲状态,接通电源并连接到 WLAN 时,Google 的联邦学习和分析服务器就可以邀请该手机与其他数百部手机一同加入到 “一轮” 联邦分析计算中。处于同一轮的每部手机将计算其 “闻曲知音” 历史记录中歌曲的识别率,并使用 安全聚合协议 (Secure Aggregation Protocol) 对计算结果进行加密。加密数据随后会发送至联邦分析服务器,且服务器没有单独解密的密钥。在与本轮其他手机的已加密计数聚合后,服务器将能(且仅能)解密所有歌曲计数的最终识别率。

利用得到的结果,Google 工程师可以改进歌曲数据库(如,确保音乐数据库包含真正的热门歌曲),而无需知道任何手机收听的歌曲信息。在第一次改进迭代中,这项技术让全球所有 Pixel 手机的歌曲总识别率提高了 5%。

使用安全聚合确保联邦分析的安全性

安全聚合 可以为联邦分析应用提供更强大的隐私保护。关于安全聚合协议的直观介绍,以歌曲识别评估问题的一个简单版本为例:

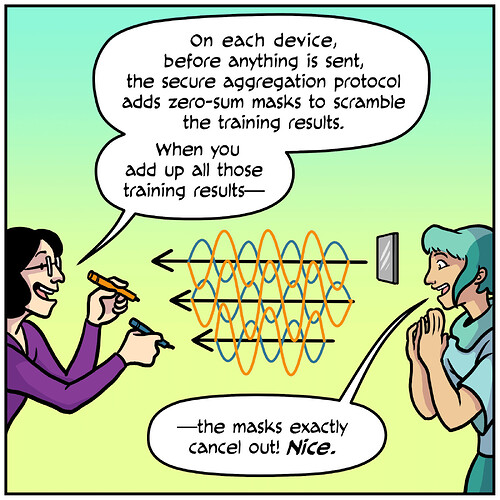

假设 Rakshita 想知道她的朋友 Emily 和 Zheng 听某一首歌曲的频率。Emily 已听过这首歌 SEmily 次,而 Zheng 听过 SZheng 次,但两人均不愿意将数据与 Rakshita 分享,也没有相互分享。因此,这三人可以执行一次安全聚合:Emily 和 Zheng 共同决定一个随机数 M,并对 Rakshita 保密。Emily 告知 Rakshita SEmily + M 的和,而 Zheng 披露 SZheng - M 的差。Rakshita 实际上看到的是两个随机的数字(真实数值 被 M 掩盖),但她可以将这两个数字相加 ( SEmily + M ) + ( SZheng - M ) = SEmily + SZheng ,以揭示 Emily 和 Zheng 共同聆听该歌曲的总次数。

通过对更多人的听歌次数进行求和,或将较小的随机值添加到计数中,可加强这种方法的隐私性(例如,利用 差分隐私技术 )。在向工程师展示结果之前,“闻曲知音” 功能会将数百部设备的歌曲识别率相加。

安全聚合协议插图,来自 联邦学习漫画

推动提升联邦学习与分析的隐私性

联邦分析方法是时下热门研究领域,热度已超越指标和计数分析。有时,使用联邦学习训练 ML 模型可用于获取设备上数据的汇总分析结果,从而原始数据将保留在设备端。例如,Gboard 工程师希望了解用户近期键入的新词语,并将其添加到拼写检查和输入建议的字典中。在这一过程中,他们无法看到用户键入的 任何 字词。通过在手机上训练字符级循环神经网络,且在训练时仅使用已在手机上键入但尚未加入全局字典的字词,他们成功实现了此目标。用户键入的所有字词数据无需离开手机,但是训练后的模型可以在数据中心中生成频繁键入的字符序列的样本,也就是新词语!

此外,我们也正在开发其他技术,希望通过训练联邦生成模型回答有关去中心化数据集且模棱两可的问题,例如 “我的模型在识别哪些数据模式时有困难?”。与此同时,我们也正在研究用户级差分私有模型训练的应用方法,以进一步确保此类模型不会对任何一位用户唯一信息进行编码。

不管是通过数据中心的差分隐私保护数据安全,还是推动提升数据收集过程中的隐私性,Google 对 隐私原则 的坚持将推动用户数据安全保障领域取得更多进展。Google 最早的去中心化数据分析系统 RAPPOR 于 2014 年推出。自此以后,即使存在大量的干扰数据(通常因 局部差分隐私方法 而引入),我们也学习到了大量有关如何做出有效决策的知识。我们将继续研究联邦分析在这一方面的应用。

联邦分析方法仍处于初期阶段,如果要更准确地回答常见的数据科学问题,还需要进一步优化。近期发表的 联邦学习中的进展和开放性问题 (Advances and Open Problems in Federated Learning) 论文对联邦研究展开了全面的调查,而 利用差分隐私进行联邦大流量项目发现 (Federated Heavy Hitters Discovery with Differential Privacy) 一文则介绍了一种用于发现数据集中最频繁项目的联邦分析方法。

借助联邦分析,我们将能以去中心化数据和隐私保护为中心,通过各种不同的方式研究数据科学。我们期待各位在这个新兴领域做出新的贡献,实现新的拓展。

致谢

本文的顺利发布需感谢以下人士的大力支持:Blaise Agüera y Arcas、Galen Andrew、Sean Augenstein、Françoise Beaufays、Kallista Bonawitz、Mingqing Chen、Hubert Eichner、Úlfar Erlingsson、Christian Frank、Anna Goralska、Marco Gruteser、Alex Ingerman、Vladimir Ivanov、Peter Kairouz、Chloé Kiddon、Ben Kreuter、Alison Lentz、Wei Li, Xu Liu、Antonio Marcedone、Rajiv Mathews、Brendan McMahan、Tom Ouyang、Sarvar Patel、Swaroop Ramaswamy、Aaron Segal、Karn Seth、Haicheng Sun、Timon Van Overveldt、Sergei Vassilvitskii、Scott Wegner、Yuanbo Zhang、Li Zhang 和 Wennan Zhu。

原文: Federated Analytics: Collaborative Data Science without Data Collection

中文发布:TensorFlow 公众号